Avec l’apprentissage profond, l’intelligence artificielle va-t-elle dépasser l’Homme ?

Publié en ligne le 16 août 2020 - Intelligence Artificielle -

Depuis qu’AlphaGo, un programme informatique, a battu les meilleurs joueurs de go [1] en utilisant, entre autres techniques, un réseau de neurones formels doté d’un mécanisme d’apprentissage profond (deep learning), les médias se sont mis à rêver et à attribuer à cette technologie la capacité de régler tous les problèmes rencontrés jusque-là en intelligence artificielle (IA).

La presse, mais aussi certains acteurs du domaine imaginent que cette technique permettrait de créer (ou a déjà permis de créer ?) une véritable intelligence artificielle... dont il faudrait se méfier car elle pourrait considérer que l’espèce humaine est trop primitive et décider qu’il est inutile de la maintenir sur Terre. Ainsi, Elon Musk, fondateur de l’entreprise Tesla, déclarait : « Si je devais me prononcer sur ce qui représente la plus grande menace pour notre existence, je dirais probablement l’intelligence artificielle. Je suis de plus en plus enclin à penser qu’il devrait y avoir une régulation, à un niveau national ou international, simplement pour être sûr que nous ne sommes pas en train de faire quelque chose de stupide. Avec l’intelligence artificielle, nous invoquons un démon » [2].

Mais remettons quelques pendules à l’heure.

L’intelligence artificielle ne se réduit pas aux réseaux de neurones

Les méthodes mettant en œuvre des réseaux de neurones ne sont pas, de très loin, les seules qui participent aux développements d’applications en intelligence artificielle.

Le programme AlphaGo n’est d’ailleurs pas seulement un réseau de neurones, il comporte aussi des règles du jeu programmées soigneusement et classiquement ainsi que des techniques d’affichage à l’écran, un puissant algorithme de recherche (exploration combinatoire) 1, un mécanisme de supervision pour organiser l’apprentissage et une multitude d’ajustements pour paramétrer le dispositif, paramétrages qui n’étaient pas évidents avant qu’à force d’essais, on en découvre une bonne version [3, 4].

Peter Diamandis est l’un des fondateurs de l’Université de la singularité [1], une organisation californienne d’inspiration transhumaniste. En 2018, il a interrogé diverses personnes qu’il présente comme pertinentes à propos de ce qui se passera dans les vingt prochaines années et a produit une synthèse des réponses [2]. Voici quelques-unes de ces anticipations (en sélectionnant certaines de celles qui se rapportent spécifiquement à l’intelligence artificielle – traduction par nos soins). Précisons qu’elles ne font pas l’unanimité des spécialistes du domaine. Mais elles illustrent le très grand optimiste de leurs auteurs.

2020 : Les diagnostics médicaux et les recommandations thérapeutiques basés sur l’IA sont utilisés dans la majorité des soins de santé aux États-Unis.

2022 : Les gens peuvent voyager légalement dans des voitures autonomes partout aux États-Unis. Tous les jouets pour enfants sont « intelligents », avec une fonction d’apprentissage automatique intégrée. Les robots sont monnaie courante dans la plupart des foyers à revenu intermédiaire. Ils sont capables de lire de manière fiable sur les lèvres et de reconnaître les mouvements du visage, de la bouche et des mains.

2024 : L’intelligence augmentée (à l’aide de programme d’IA) est considérée comme une exigence pour la plupart des emplois professionnels.

2026 : La réalité virtuelle est devenue omniprésente. Les parents se plaignent que leurs enfants sont constamment dans un autre univers. Les voyages commencent à décliner car la réalité virtuelle devient suffisamment

bonne pour ressentir bon nombre des sensations d’un lieu sans souffrir des tracas du voyage.

2028 : Les robots ont de vraies relations avec les humains en accompagnement du vieillissement, pour l’hygiène personnelle et pour la préparation des aliments. Les robots sexuels deviennent populaires.

2030 : Une intelligence artificielle réussit le test de Turing.

2032 : La majorité des professionnels humains ont subi des modifications corticales, notamment l’implantation de coprocesseurs et de fonctions de communication Internet en temps réel. Les robots avatars deviennent populaires, permettant à chacun de « téléporter » sa conscience vers des endroits éloignés, partout dans le monde. La présence de robots sur les lieux de travail est courante. Ils prennent en charge tous les travaux manuels et les tâches répétitives (par exemple, réceptionnistes, guides touristiques, chauffeurs, pilotes, ouvriers du bâtiment). Des entreprises ont établi des connexions importantes et fiables entre le cortex humain et le Cloud.

2038 : La vie quotidienne est désormais méconnaissable – incroyablement bonne, avec une généralisation de la réalité virtuelle et de l’intelligence augmentée rendues disponibles partout dans le monde et pour toutes les facettes des activités humaines.

1 | Site de l’Université de la singularité (Singularity University) : su.org

2 | Diamandis P, “Countdown to the singularity” (Le compte à rebours de la singularité). Sur diamandis.com.

Dans les travaux sur les véhicules autonomes – qui pour l’instant ne le sont pas suffisamment pour qu’on les laisse circuler sans mécanicien à bord prêt à chaque instant à reprendre la main –

les réseaux de neurones ne représentent qu’une très faible partie des programmes utilisés [5], tout le reste consistant en de la modélisation 3D, du calcul de trajectoires pour anticiper les mouvements, et l’assemblage de systèmes plus ou moins classiques en robotique.

Bien des applications de l’IA n’utilisent pas ou très peu d’apprentissage profond, même si – parce que c’est la mode – on essaie de l’introduire un peu partout. Par exemple, en mathématiques, les assistants de preuves (devenus importants pour valider les démonstrations, certifier des circuits électroniques et prouver le bon fonctionnement des logiciels utilisés en aéronautique) ont été développés sans utiliser la méthode d’apprentissage profond, que l’on n’a introduite que récemment. Même sans apprentissage profond, ces systèmes font un véritable travail intellectuel difficile : ils raisonnent et calculent mieux que les spécialistes qui les utilisent.

Même si, aujourd’hui, on tente de mettre de l’apprentissage profond et des réseaux de neurones formels un peu partout, c’est une erreur de considérer que l’IA commence avec cette technique, et une illusion de croire qu’elle remplacera toutes les autres méthodes.

L’apprentissage profond va-t-il dépasser l’Homme ?

Il n’est pas vrai qu’on réussit avec les méthodes d’apprentissage profond à égaler ou dépasser de nombreuses performances humaines.

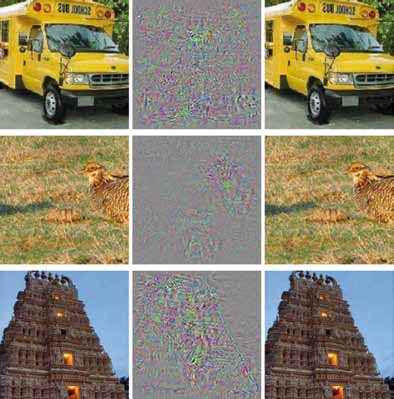

© Images extraites de Szegedy C et al., “Intriguing properties of neural networks, International Conference on Learning Representations”, prépublication arXiv, 2014, 1312.6199.

Pour qu’un programme à base de réseaux de neurones reconnaisse un chat dans une nouvelle image, il aura fallu au préalable lui montrer un très grand nombre d’images de chats. Les humains apprennent à partir de bien moins d’exemples. De nombreuses faiblesses des réseaux de neurones ont été identifiées depuis longtemps [6] : impossibilité d’expliquer les résultats proposés, difficultés à manipuler des informations symboliques et plus encore à enchaîner des éléments de raisonnements (tous les hommes sont mortels, Socrate est un homme...).

Apprentissage profond facile à berner ?

Insistons sur l’un de ces défauts inquiétants : les systèmes fondés sur les techniques d’apprentissage profond peuvent se faire duper. Des chercheurs ont en effet mis au point des méthodes pour leur faire prendre certaines vessies pour des lanternes. Par exemple, en collant quelques papiers sur un panneau « stop », une équipe a réussi à faire croire au réseau de neurones chargé de lire des panneaux de circulation routière qu’il s’agissait d’un panneau de limitation de vitesse à 45 km/h. On pourra trouver en [7, 8, 9, 10] des précisions sur ce genre de techniques trompant l’apprentissage profond.

En résumé, les méthodes d’apprentissages peuvent traiter rapidement des millions de données – ce que nous ne sommes pas capables de faire –, mais les résultats obtenus restent limités à quelques domaines que l’on tente d’élargir, sans réussir nécessairement, et avec parfois de mauvaises surprises à cause d’une fiabilité décevante.

Risques réels et risques fantasmés

L’IA fait courir des risques, mais aujourd’hui ce ne sont pas ceux d’une révolte contre l’espèce humaine. Le vrai danger se trouve dans les bugs qu’on ne pourra pas éliminer facilement des applications et dans la trop grande confiance qu’on risque d’accorder à des dispositifs d’IA. La voiture Uber qui a renversé et tué une passante en 2018 dans l’Arizona ne l’a pas fait parce qu’elle s’est révoltée, mais parce qu’elle était mal programmée et qu’on lui a fait trop confiance ; elle aurait confondu la passante avec un carton poussé par le vent [11, 12].

Le problème de la révolte des robots se posera peut-être un jour, mais ce n’est pas tout de suite et ce n’est pas certain car les robots avancés réellement intelligents, s’il en existe un jour, seront notre prolongement, en quelque sorte d’autres nous-mêmes. Et même s’ils devenaient aussi intelligents que nous, ou plus, les robots intelligents se retrouveraient embarqués dans nos conflits humains – c’est d’ailleurs déjà le cas –, et seraient associés à chaque camp plutôt que d’en constituer un nouveau, contre nous.

Avant que le problème se pose d’une guerre entre humains et IA, qu’au fond je crois absurde, beaucoup d’eau passera sous les ponts. L’IA avancera petit à petit et pas seulement grâce à l’apprentissage profond. À cause des imperfections que contiendront inévitablement les systèmes d’IA, elle sera la cause, comme n’importe quelle autre technologie, de pannes, d’accidents et de dysfonctionnements aux conséquences parfois mortelles, comme on l’observe dans de nombreux domaines (automobile, aviation, industrie chimique, etc.).

Ce que nous devons craindre, ce n’est pas trop l’intelligence des systèmes IA qui nous regarderait de haut, mais une insuffisante évaluation des limites d’intelligences incomplètes, mal conçues, mises en marche sans précaution ou bêtement défaillantes comme nos voitures, nos avions, nos ordinateurs et tout ce qui est complexe et dont la mise au point ne s’opère que lentement et péniblement.

1 | AlphaGo, page Wikipedia.

2 | Karayan R, « Intelligence artificielle : attention danger, même Bill Gates a peur ! », L’Express, 2 février 2015. Sur lexpansion.lexpress.fr.

3 | “Deep Mind, AlphaGo Zero : Starting from scratch”, ->https://deepmind.com/blog/article/alphago-zero-starting-scratch], 18 octobre 2017. Sur deepmind.com.

4 | Silver D et al., “Mastering the game of go without human knowledge”, Nature, 2017, 550 :354-9.

5 | Le Lann G, « Questions à propos des véhicules autonomes », enquête du Comets (comité d’éthique du CNRS), 2019.

6 | Marcus G, “Deep Learning : A Critical Appraisal”, prépublication arXiv, 2018, 1801.00631. Sur arxiv.org.

7 | Heaven D, “Why deep-learning AIs are so easy to fool”, Nature, 2019, 574 :163-6.

8 | Delahaye JP, « Intelligences artificielles : un apprentissage pas si profond ! », Pour la science, mai 2018, 80-5.

9 | Eykholt K et al.,“Robust physical-world attacks on deep learning visual classification”, Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2018, 1625-34.

10 | Soll M, “InformatiCup Competition 2019 : Fooling Traffic Sign Recognition”, in : KI 2019 : Advances in Artificial Intelligence, Springer, 2019, 325-32.

11 | Reuters, “In review of fatal Arizona crash, U.S. agency says Uber software had flaws”, 2018. Sur reuters.com

12 | Charnay A, « Pourquoi la voiture autonome d’Uber a tué un piéton », 01 Net, 2018. Sur 01net.com

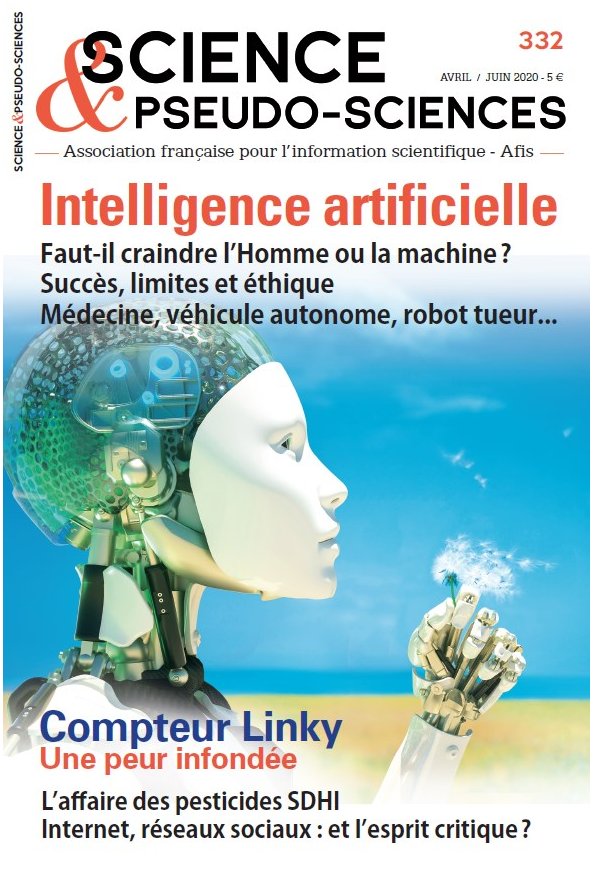

La revue Science et pseudo-sciences est réalisée par une équipe de bénévoles adhérents de l’Afis. Elle s’attache à traiter des sujets de fond et prépare ses articles et dossiers longtemps à l’avance. Le numéro que vous avez entre les mains a été finalisé dans son contenu au mois de janvier 2020. Dans ces conditions, bien entendu, il ne nous a pas été possible d’aborder le sujet de la pandémie de coronavirus Covid-19 et ses développements récents autrement que dans l’éditorial. Si les abonnés recevront bien leur exemplaire via les services postaux, la diffusion en points de vente (maisons de presse, kiosques, etc.) sera vraisemblablement perturbée. Le numéro est toutefois en vente dans la boutique en ligne sur notre site, tout comme les numéros précédents.

1 L’ensemble des coups autorisés à partir d’une situation dans la partie est représenté sous la forme d’une arborescence gigantesque qu’un algorithme va exploiter pour identifier le coup à jouer qu’il estime le meilleur.

Publié dans le n° 332 de la revue

Partager cet article

L' auteur

Jean-Paul Delahaye

est professeur émérite à l’université de Lille et chercheur au Centre de recherche en informatique signal et (...)

Plus d'informationsIntelligence Artificielle

L’intelligence artificielle (IA) suscite curiosité, enthousiasme et inquiétude. Elle est présente dans d’innombrables applications, ses prouesses font régulièrement la une des journaux. Dans le même temps, des déclarations médiatisées mettent en garde contre des machines qui pourraient prendre le pouvoir et menacer la place de l’Homme ou, a minima, porter atteinte à certaines de nos libertés. Les performances impressionnantes observées aujourd’hui sont-elles annonciatrices de comportements qui vont vite nous échapper ?

Intelligence artificielle

Le 16 août 2020

IA génératives : une révolution en cours ?

Le 17 octobre 2023

De l’analyse de la langue aux modèles génératifs

Le 11 octobre 2023

Les systèmes d’intelligence artificielle pour la génération d’images

Le 5 octobre 2023

IA génératives : un risque accru de désinformation ?

Le 29 septembre 2023