La théorie du Big Bang rend bien compte des décalages observés

Publié en ligne le 11 juin 2011 - Astrologie -Cet article est une réponse à La maladie infantile de la cosmologie : le Big Bang chaud, par Jean-Claude Pecker.

Pour comprendre la controverse autour du Big-Bang, il est nécessaire de remonter aux débuts de la cosmologie, lorsque Hubble découvrit en 1930 que les spectres des galaxies sont décalés vers les grandes longueurs d’onde, « vers le rouge », et que le décalage – que l’on a pris l’habitude d’appeler du mot anglais de « redshift » – est proportionnel à leur distance 1. Comme il traduisait ce décalage en termes de vitesse d’éloignement conformément à « l’effet Doppler-Fizeau », il en déduisait que les galaxies s’éloignent de nous d’autant plus rapidement qu’elles sont plus distantes, ce qu’il interpréta par l’expansion de l’Univers dans son ensemble. Cette découverte infirmait la cosmologie « stationnaire » d’Einstein et de De Sitter, mais corroborait par contre celle de Friedman, disparu quelques années avant sans avoir appris cette grande nouvelle. Deux ans plus tard, l’abbé Lemaître développait une idée qui préfigurait le Big-Bang, celle de « l’atome initial ». En remontant dans le temps l’expansion de l’Univers, il débouchait automatiquement sur une « naissance », et un « âge » de l’ordre de l’inverse de la constante de Hubble 2. Cet âge était petit, il était seulement de deux milliards d’années. Dans les années 1950, on fut en mesure de dater les amas d’étoiles les plus anciens et de montrer qu’ils étaient âgés d’au moins dix milliards d’années. Mais, dans le même temps, la constante de Hubble fut corrigée par un facteur huit (l’erreur était due à une mauvaise estimation de la distance des Céphéides ayant servi d’étalons et à la trop petite portion d’univers explorée par Hubble), donnant un âge de l’Univers conforme à celui des plus vieilles étoiles.

Les théories alternatives au Big-Bang

Ce n’est donc pas l’âge trop petit de l’Univers, comme on le dit parfois, mais plutôt des raisons philosophiques qui poussèrent un certain nombre d’astronomes à rejeter le Big-Bang et à prôner un « Univers stationnaire ». Ainsi Bondi, Gold, et Hoyle supposèrent que la matière était créée de façon continue en chaque point de l’Univers, appliquant ce que l’on nomme le « principe cosmologique parfait » : non seulement l’Univers est identique en tout point dans l’espace, mais également dans le temps, contrairement à l’Univers avec Big-Bang, qui est identique dans l’espace, mais changeant dans le temps. C’était effectivement une théorie très séduisante, et de fait, elle fut préférée par une majorité d’astronomes à celle du Big-Bang jusqu’en 1965, car celui-ci pouvait servir d’argument à l’idée d’une création divine. Bondi, Gold et Hoyle n’étaient cependant pas opposés à l’expansion, simplement, elle aurait été infinie et constante dans le temps. D’autres allèrent plus loin encore, en prônant une origine différente au décalage spectral, d’une nature encore inconnue, telle que la fatigue de la lumière, et dans ce cas, l’Univers n’est pas en expansion mais statique.

Puis en 1965, Penzias et Wilson découvrirent le rayonnement isotrope du ciel à 3° Kelvin (c’est-à-dire à -270° centigrade). Ce rayonnement fut immédiatement interprété par une majorité de cosmologistes comme étant celui prévu dans le cadre du Big-Bang par Gamow dès les années 1940 3, et recherché sans succès par Dicke 4.

Les paradoxes des quasars

Or, on venait de découvrir à cette époque des astres extraordinaires, que l’on nomma des « quasars » (quasi-stars), car ils apparaissaient comme des étoiles (stars) sur les photographies. Une caractéristique de ces astres est que leurs raies spectrales sont décalées vers les grandes longueurs d’onde. Leur redshift atteint en valeur relative plusieurs centaines de pourcents. On aurait pu l’attribuer à une vitesse réelle (l’effet Doppler-Fizeau), mais il fallait dans ce cas expliquer pourquoi elle était toujours dirigée vers les grandes longueurs d’onde, ce qui signifiait que tous les quasars s’éloignaient de nous, donc qu’ils auraient été tous expulsés du système solaire 5 avec des vitesses extraordinairement grandes. L’explication la plus naturelle était qu’ils participaient à l’expansion de l’Univers. Et comme leurs redshifts étaient très grands, ils étaient très éloignés conformément à la loi de Hubble, plus éloignés même qu’aucun objet connu à cette époque.

Cette explication était très embarrassante pour les tenants de la théorie du Big-Bang et de façon plus générale pour tous ceux qui croyaient aux redshifts dus à la loi de Hubble. En effet, si on plaçait les quasars à leur distance donnée par la loi de Hubble (que nous appellerons par la suite « distance cosmologique »), cela signifiait qu’ils étaient prodigieusement lumineux. Or, non seulement ils ressemblaient à de simples étoiles, mais on s’aperçut que leur éclat variait sur des échelles de temps très courtes, typiquement d’une semaine (on a observé depuis des variations bien plus rapides dans le domaine des rayons X). Suivant le principe de causalité affirmant qu’une variation d’éclat ne peut être plus rapide que le temps mis par la lumière pour traverser la région émissive 6, on en déduisait que leur taille était plus petite qu’une semaine-lumière. Pour résumer, disons que leur puissance était celle de mille galaxies, dans une région de la dimension d’un millionième de galaxie ! De plus, on découvrit rapidement d’autres propriétés qui en faisaient des objets très particuliers, comme des jets de gaz se déplaçant avec des vitesses voisines de celles de la lumière, et dans certains cas avec des vitesses supérieures à celle de la lumière (en apparence du moins).

Ne fallait-il donc pas mettre en doute l’interprétation du décalage spectral par un effet Doppler ? Un certain nombre d’astronomes – en particulier tous ceux qui croyaient à l’Univers stationnaire ou statique – proposèrent donc que les quasars n’étaient pas situés à leur distance cosmologique, mais qu’ils étaient beaucoup plus proches et que leur redshift était dû à une cause physique encore inconnue, telle que la fatigue de la lumière déjà mentionnée. Ce fut « la controverse des redshifts anormaux » qui battit son plein pendant une dizaine d’années, car on n’avait pas encore trouvé les explications de certains paradoxes que posaient les quasars.

Pourtant, deux grands astrophysiciens, l’américain Salpeter et le russe Zeldovich, avaient proposé indépendamment, peu après la découverte des premiers quasars, qu’il devait s’agir de « trous noirs géants » attirant la matière environnante. Elle rayonne alors une fraction importante de son énergie de repos juste avant de franchir « l’horizon » du trou noir. La puissance rayonnée, de même que la taille de ces trous noirs, étaient tout à fait comparables à celles des quasars, en les supposant à leur distance cosmologique. Cette théorie ne fut réellement acceptée par la communauté astronomique qu’à la fin des années 1970 (en particulier grâce à la découverte d’autres astres étranges, les pulsars). Des preuves convaincantes de l’existence de tels trous noirs ont été données depuis, en particulier avec l’observation d’un trou noir géant au centre de la Voie Lactée. Et c’est devenu maintenant un paradigme de dire que la puissance des quasars est due à « l’accrétion sur un trou noir supermassif ».

Tous les phénomènes paradoxaux accompagnant les quasars ont été alors expliqués dans ce cadre de la physique « conventionnelle ». Mais il y a plus. Car les simulations par ordinateur permettent maintenant de rendre compte de l’évolution des quasars et des galaxies au cours des temps cosmiques ; et ce, dans le cadre du scénario standard de structuration de l’Univers, qui débute au moment de l’émission du rayonnement cosmologique, soit 380000 ans après le Big-Bang pour les partisans de l’expansion de l’Univers. On commence dans ce cadre à comprendre pourquoi les quasars étaient beaucoup plus puissants et nombreux dans le passé que maintenant, pourquoi presque toutes les galaxies contiennent un trou noir supermassif, pourquoi la formation des étoiles s’est produite en même temps que celles des quasars, pourquoi l’enrichissement en éléments lourds de ces derniers s’est produit très rapidement, toutes questions qui ont interpellé les astronomes pendant plusieurs décennies.

Des décalages dus à l’expansion de l’Univers

De plus, il faut se rendre à l’évidence : il est clair que le redshift est entièrement cosmologique (c’est-à-dire dû à l’expansion de l’Univers) dans la plupart des quasars. Pour ceux qui sont situés à moins de dix milliards d’années-lumière (les deux tiers de la taille de l’Univers observable), on parvient à détecter, avec les grands télescopes, les galaxies au sein desquelles ils se trouvent et on vérifie que leur redshift est le même que celui du quasar. De même, pour ceux qui sont situés dans des amas de galaxies lointains. Par ailleurs, on observe dans les spectres des quasars des raies sombres ayant des redshifts moins élevés que celui du quasar, et l’on constate que ce sont les mêmes que ceux des galaxies se projetant sur le ciel tout près du quasar : les raies sombres sont donc produites par des « nuages interstellaires » situés sur la ligne de visée du quasar plus éloigné. Enfin, les « mirages gravitationnels » prévus dans le cadre de la Relativité Générale (« l’effet Einstein ») révèlent des images multiples de quasars situés derrière des amas de galaxies lointains et massifs dont la gravité dévie les rayons lumineux, comme dans le cas de la fameuse « Croix d’Einstein ».

D’ailleurs, les observations de ces raies sombres contribuent non seulement à vérifier les grandes distances des quasars, mais elles confortent également l’origine cosmologique du rayonnement à 3 degrés K. En effet, on connaissait depuis longtemps l’existence de deux raies spectrales en absorption dans les spectres stellaires, créées par les molécules de cyanogène du gaz interstellaire et provenant de deux niveaux d’énergie très proches. On avait découvert que le niveau d’énergie supérieur était excité par un rayonnement de 3K qui semblait le même dans toutes les directions du ciel. Dans les années 1990, ces raies ont été observées dans les spectres de quasars lointains, et l’on a trouvé que la température d’excitation du niveau supérieur croissait comme le redshift, exactement comme le prédit l’expansion de l’Univers, excluant en particulier une origine locale du 3K.

Les « décalages anormaux »

Il ne reste donc à la communauté des « non orthodoxes » qu’à admettre que la plupart des quasars ont bien un redshift cosmologique, et que seule une petite fraction d’entre eux possède éventuellement des « redshifts anormaux », c’est-à-dire non dus à la loi de Hubble. Et c’est ici que se pose à mon sens l’un des problèmes les plus difficiles à résoudre. Il semble en effet étrange que les quasars se partagent en deux populations, l’une constituée d’objets proches et peu lumineux ayant un redshift d’origine inconnu, l’autre d’objets lointains et très lumineux, cette dernière catégorie ayant d’ailleurs une propension à remplacer la première à mesure que les techniques d’observation évoluent… Et qu’elles aient toutes les deux des caractéristiques identiques dans tous les domaines de longueur d’onde. Prenons l’exemple des raies spectrales. Tous les quasars, ayant ou non des « redshifts anormaux », proches ou lointains, présentent les mêmes raies spectrales. On sait de nos jours que leurs longueurs d’onde ne varient pas jusqu’à des distances de plus de dix milliards d’années-lumière dans une proportion supérieure à un millionième (mis à part le « redshift », bien entendu). Leurs conditions d’émission obéissent donc à des lois connues, qui sont les mêmes ici ou aux confins de l’Univers. Elles traduisent des conditions physiques identiques, celles de plasmas très chauds ou bien de nuages moléculaires froids tout à fait communs. Comment expliquer alors qu’exactement les mêmes phénomènes se manifestent dans des objets où s’appliquent les lois de la physique ordinaire, et dans ceux qui sont gouvernés par une loi mystérieuse et inconnue ? Dit autrement, pourquoi tous les phénomènes seraient exactement les mêmes, sauf les redshifts ?

On peut se demander pourquoi il a été et il est encore si difficile de statuer sur ce problème des décalages anormaux. C’est que, outre les phénomènes mentionnés plus tôt, un astronome américain, Halton Arp, photographe hors pair, publiait sans cesse d’étranges observations. Il fut pendant presque trente ans membre de l’Observatoire du Mont Palomar et avait donc un accès facile au télescope de cinq mètres. Il est d’ailleurs l’auteur d’un Atlas de galaxies particulières où l’on trouve de nombreuses galaxies de formes extraordinaires qui ont été étudiées en détail par la suite. Il a découvert de bizarres alignements de quasars, des redshifts semblant répondre à des récurrences ou à des lois d’exclusion, des quasars situés à côté de galaxies brillantes proches auxquels ils sont joints par un pont de matière, des groupes de galaxies et de quasars dans lesquels un membre n’a pas le même décalage que les autres, etc. Pour Arp et les « non-orthodoxes », les « quasars » en question sont des objets éjectés par les galaxies, dont le redshift se compose d’une partie cosmologique (celui de la galaxie proche), d’une partie due à la vitesse (mais elle doit être négligeable car, sinon, on observerait des décalages spectraux vers le bleu), et d’une partie « intrinsèque », la plus importante, due à une loi de la physique encore inconnue. Pour les « orthodoxes », il s’agit de coïncidences sur le ciel dues au hasard.

L’essence de la controverse est donc statistique. La méthode que Arp a souvent utilisée est biaisée de ce point de vue. En effet, il partait d’une galaxie et cherchait ce qui pouvait exister de curieux autour. Sur le nombre il trouvait évidemment certains cas bizarres dont la probabilité paraissait extrêmement faible. Le problème réside dans ce qui est statistique a priori et statistique a posteriori. Tant que le nombre de quasars était très réduit et qu’ils étaient distribués de façon inhomogène sur le ciel pour des raisons diverses, il était difficile de leur appliquer les règles des statistiques a priori. Mais maintenant il n’est plus question d’explorer seulement un bout d’Univers, puisque l’on voit des galaxies et des quasars jusqu’à des distances proches de l’horizon observable, qui existaient il y a treize milliards d’années lorsqu’il avait moins de 5 % de son âge actuel (si l’on admet le Big-Bang). Et depuis que d’énormes régions du ciel ont été explorées et ont livré tous les quasars et galaxies qu’elles contiennent, y compris les plus faibles, on constate que les probabilités a priori ont tendance à augmenter rapidement.

Ainsi l’un des cas les plus discutés il y a trois ou quatre décennies était celui du « quintet de Stéphan ». En 1961 Geoffrey et Margaret Burbidge montrèrent que le redshift de l’une des galaxies du groupe était huit fois plus petit que celui des quatre autres. Cela signifiait qu’elle était plus proche. Comme les Burbidge estimaient à moins de 1/1000 la probabilité qu’elle se profilât par hasard sur le ciel devant le groupe des quatre autres galaxies, ils en déduisaient que celles-ci avaient des décalages non cosmologiques. Or il a été prouvé depuis que la galaxie ayant le petit redshift est dix fois plus proche que les autres, et l’on a trouvé bien d’autres cas de ce genre. Il faut noter aussi que les découvreurs d’excès de quasars autour de galaxies (ce qui fait penser effectivement à une éjection à partir de ces galaxies, comme le prônait Ambarzumian) constatent eux-mêmes que la fraction de cas « anormaux » tend à diminuer et à être de moins en moins significative à mesure que l’on utilise des relevés de plus en plus grands (comme le fameux « Sloan Digital Sky Survey » qui contient des millions de galaxies et des centaines de milliers de quasars dont les redshifts sont connus, voir Lopez-Corredoira, 2009, Arxiv :0901.4534v1). De plus, « l’effet Einstein » dont nous avons parlé crée non seulement de multiples images du même quasar, mais amplifie également leur éclat, augmentant ainsi la proportion de fausses associations. Le hasard pourrait être donc à l’œuvre sans avoir besoin de faire intervenir une physique nouvelle.

Dans le « Catalogue of discordant redshift associations » publié par Arp en 2003 sont présentées de nombreuses photographies d’associations de quasars et de galaxies, ou de quasars avec des quasars. En particulier, on a découvert de nombreux quasars entourant des galaxies proches. Une interprétation possible est que l’on a cherché ces quasars. En effet, les télescopes travaillant dans le domaine X avaient permis dans les années 1990 de détecter une foule de sources se situant à la périphérie de galaxies en train de former activement des étoiles. Leur nature était inconnue, il a donc fallu en prendre des spectres. Il en ressort que la majeure partie sont des étoiles binaires appartenant à la galaxie. L’une des composantes du couple est devenue au cours de son évolution un trou noir qui attire la matière de l’autre composante restée une étoile « normale ». De ce fait, elles sont très brillantes en X, et c’est pourquoi on les a surnommées des ULXs pour « UltraLuminous X-ray ». Mais quelques unes se sont révélées être des quasars (car ils rayonnent également beaucoup dans le domaine X). On les a donc détectés parce que l’on a étudié des sources X au voisinage immédiat ou même à l’intérieur des galaxies.

Les cas plus importants à retenir pour notre discussion sont donc plutôt ceux (une dizaine) qui montrent des ponts de matière entre objets de redshifts différents. Pour les autres, nous laisserons l’avenir trancher entre les redshifts anormaux et les superpositions dues au hasard.

L’un des problèmes majeurs est alors de tenir compte des artefacts dûs à la résolution spatiale des photographies. La résolution des instruments au sol est en effet limitée par la turbulence atmosphérique et, à moins d’utiliser les plus récents équipements d’ « optique adaptative », ce qui n’est pas le cas du catalogue de Arp, elle est d’une demi-seconde de degré dans le domaine visible pour les meilleurs sites.

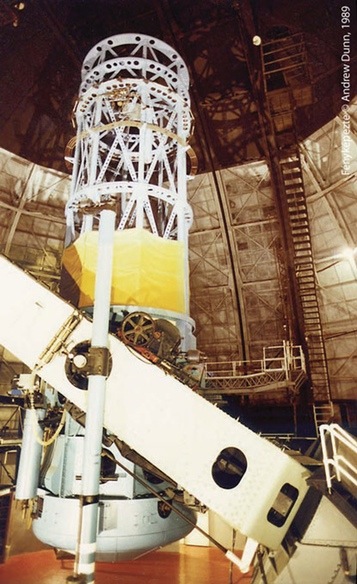

Le cas qui a fait le plus couler d’encre est sans conteste le couple formé par la galaxie NGC 4319 et le quasar Markarian 205 : ces deux objets dont les décalages diffèrent par un facteur douze, semblaient reliés par un pont de matière, jusqu’à ce que l’on obtienne récemment des images prises avec le télescope spatial Hubble – dont la résolution est 0, 02 seconde de degré – montrant que la connexion entre les deux objets semble interrompue. Il reste bien une petite irrégularité entre les deux objets, mais de telles irrégularités existent à d’autres endroits sur les images.

Un autre exemple montré par Arp est celui de deux quasars, 3C273 (le premier quasar à avoir été identifié), de redshift 0,158, et 3C279, de redshift 0,538. Il s’agit d’une carte en rayons gamma révélant une faible extension entre les deux objets. Mais lorsqu’on sait que la résolution de l’instrument de mesure était de deux degrés ( !), on doute que l’extension ait une signification. Et de fait, dans les autres domaines de longueurs d’onde pour lesquels la résolution est bien meilleure, les deux quasars sont complètement séparés, sans la moindre trace de connexion. Pour l’association bien connue entre le quasar 3C232 et la galaxie NGC 3067, dans lequel une « queue » d’hydrogène neutre de la galaxie pointe vers le quasar, il a été montré que les deux objets ne peuvent être associés physiquement car l’hydrogène serait alors ionisé par le quasar. Celui-ci est donc est bien un objet distant se profilant derrière la galaxie.

Un autre cas présenté est de celui deux quasars situés de part et d’autre d’une galaxie proche (NGC 4258). Ici, il n’existe pas de connexion visible, mais les deux quasars sont à peu près symétriques par rapport au noyau de la galaxie, faisant penser à une éjection. Si c’était le cas, on devrait observer un petit mouvement des quasars s’éloignant de la galaxie. On a pu montrer grâce à des observations interférométriques suivie dans le temps que leur vitesse est inférieure à 15000 km/s. Il est encore trop tôt pour se prononcer, mais dans quelques années cette limite inférieure sera réduite, et peut-être pourra-t-on conclure que les deux quasars ne sont pas éjectés par la galaxie. Et l’on pourrait continuer ainsi pour chaque cas…

Cependant, il faut reconnaître qu’il existe quelques exemples d’associations de quasars et de galaxies qui ne rentrent pas facilement dans le cadre « cosmologique », car ils correspondent à des probabilités très faibles d’exister. Le plus spectaculaire est celui de la galaxie NGC 7603 qui semble connectée à une galaxie de redshift différent par un filament étroit à l’intérieur duquel se trouvent encore deux autres objets de plus grand redshift. Pour ces objets, il faudra attendre les « extrêmement grands » télescopes qui verront le jour dans les années 2020 avant d’avoir une réponse.

Ainsi, il faut aller jusqu’à un haut degré de sophistication dans l’analyse pour être sûr qu’elle ne soit pas biaisée par de multiples effets, même minuscules ; et par conséquent c’est un énorme travail que de réfuter ou d’accepter chaque cas, chacun étant à la limite des possibilités observationnelles et des erreurs statistiques.

La controverse sur les décalages anormaux s’épuise

La « controverse des redshifts » a été très vive pendant une dizaine d’années, puis elle s’est calmée et de moins en moins d’astronomes ont pris part au débat. Qu’est-ce donc qui a conduit à la désaffection de ce problème ?

Plusieurs raisons à cela.

La première est que trop de « mauvais » exemples ont été donnés. Comme le dit l’un des partisans des redshifts anormaux, qui fait lui-même beaucoup d’efforts pour les valider par des observations précises, l’espagnol Martin Lopez-Corredoira (2009) : « Les supporters principaux de l’hypothèse des redshifts non-cosmologiques continuent de produire des dizaines d’analyses en faveur de leurs idées sans prendre suffisamment de soin, montrant dans beaucoup de cas des images qui ne sont pas accompagnées d’une analyse statistique rigoureuse, avec de mauvaises identifications, des probabilités sous-estimées, des biais, utilisant des relevés incomplets. Il existe cependant de nombreux articles dans lesquels sont présentés des objets tout à fait intéressants, mais la communauté les ignore, simplement à cause de la mauvaise réputation du sujet. Dans ce panorama, il sera difficile de résoudre rapidement le problème ».

Une autre raison est que l’on peut comparer ce cas à celui des OVNI : on ne peut les réfuter tous ou bien notre temps y serait entièrement consacré. Car chaque fois qu’une observation étrange est expliquée, il s’en trouve de nouvelles. Cela pourrait continuer indéfiniment puisque le ciel est immense et contient des milliards d’objets dont il est maintenant possible d’obtenir une image et dont certains ont des particularités curieuses. Peu de jeunes astronomes éprouvent l’envie de passer leur temps à montrer que tel alignement peut être dû au hasard, ou que tel quasar est bien situé derrière la galaxie près de laquelle il semble se trouver, car c’est une étude difficile et très consommatrice de temps. D’autant qu’il faut mentionner l’ostracisme des éditeurs auxquels sont soumis les livres et les articles des tenants des redshifts anormaux et de l’Univers Stationnaire, lorsqu’ils ne s’en tiennent pas à la simple analyse de faits observationnels. Ce qui constitue évidemment un repoussoir pour des chercheurs tentés par le sujet mais qui ont absolument besoin de publier.

Mais il y a une autre raison d’ordre supérieur. C’est qu’il n’a jamais été proposé pendant quarante ans aucun cadre théorique général dans lequel insérer cette série de faits disparates. Bien sûr, les tenants de l’Univers quasi-stationnaire (qui est fondé sur des principes théoriques sérieux), Hoyle, Burbidge, Narlikar, avaient tenté sans succès d’intégrer ces observations dans leur théorie. Hoyle avait suggéré que la matière prenait naissance dans les noyaux des galaxies, rejoignant en cela les anciennes idées d’Ambartsumian. Mais cela est resté au niveau de spéculations. Et de ce point de vue, les idées de Arp lui-même sont rien moins que convaincantes.

En son temps, le débat a été fascinant non seulement à cause de son importance scientifique, mais également par ce qu’il a révélé sur les personnalités et les différentes conceptions de la science. Pourquoi en effet tant de passions se sont-elles déchaînées dans cette discussion ? Il est certes normal et même indispensable au bon déroulement de la recherche d’avoir une démarche critique et de remettre en cause en permanence ce qui est acquis, y compris les paradigmes les mieux implantés. Beaucoup l’oublient et n’écoutent que ce qui rentre dans le cadre des idées à la mode. Les promoteurs d’une idée iconoclaste pensent donc, parfois à juste titre, qu’ils sont porteurs d’une vérité et qu’ils doivent à tout prix l’imposer à des scientifiques conservateurs et frileux. Ce fut le cas pour les grandes coupures épistémologiques comme la révolution copernicienne ou galiléenne. Mais lorsque la démarche critique s’accompagne de la négation des connaissances précédentes et du recours à une physique nouvelle, il faut qu’elle soit sans faille, d’une parfaite rigueur, que le qualitatif et l’approximatif en soit proscrit, que la démonstration soit probante. Et il faut surtout qu’un modèle prédictif en émerge.

Rien de tout cela ne s’est produit jusqu’à maintenant avec les décalages anormaux. Je suis pourtant sûre que tous les astronomes, même les plus « orthodoxes », auraient été excités et ravis qu’un concept totalement nouveau se dégage de leur science, montrant que l’astrophysique ne se réduit pas à appliquer la physique connue dans des conditions extrêmes. Mais, comme l’écrivait Martin Rees dans les années 1980, « La théorie orthodoxe d’un phénomène est par définition la plus développée parmi les théories qui n’ont pas encore pu être éliminées empiriquement. Donc, suivre une approche orthodoxe est généralement la meilleure stratégie pour obtenir une confrontation décisive entre la théorie et l’observation qui permettra soit de renforcer l’orthodoxie, soit de l’éliminer en faveur d’une autre qui deviendra alors la nouvelle orthodoxie ».

1 En fait, c’est Slipher qui avait mesuré les vitesses des galaxies quelques années avant Hubble et constaté qu’elles s’éloignent de nous. Mais il n’avait pas pensé à déterminer leur distance, comme le fit Hubble grâce aux observations des Céphéides de Miss Leavitt (qui n’eut jamais le grade de docteur et n’avait d’ailleurs pas la permission – restreinte aux hommes – de pénétrer dans une coupole).

2 Voir sa définition dans l’article de J. C. Pecker : « Hubble établit une méthode d’évaluation de la distance des galaxies et montre que le décalage est une fonction linéaire z = Hd de la distance, où H est la « constante de Hubble ».

3 Il prévoyait que l’Univers se refroidissant et atteignant une température voisine de 3000 degrés, les protons et les électrons se « recombineraient » en donnant des atomes d’hydrogène. Les photons pourraient alors continuer leur vie sans interagir avec la matière, tout en perdant leur énergie à cause de l’expansion, et devenir des photons de 3 degrés Kelvin (en fait Gamow prévoyait plutôt 5 à 15 degrés Kelvin).

4 Gamow et Dicke n’obtinrent pas le prix Nobel pour cette prévision, contrairement à Penzias et Wilson, dont la découverte était pourtant due au hasard.

5 Si les quasars s’éloignaient tous de nous, tout en étant proches (c’est-à-dire situés à l’intérieur de notre Galaxie), cela voudrait dire qu’ils auraient été expulsés d’un endroit proche du Soleil. S’ils avaient été expulsés d’un autre endroit de la Galaxie, on en verrait se rapprocher de nous.

6 Car toute perturbation se propage avec une vitesse plus petite que celle de la lumière.

Publié dans le n° 294 de la revue

Partager cet article

L' auteur

Suzy Collin-Zahn

Astrophysicienne et directeur de recherche honoraire à l’Observatoire de Paris-Meudon.

Plus d'informationsAstrologie

L’astrologie à l’épreuve : ça ne marche pas, ça n’a jamais marché !

Le 27 décembre 2009

Exclusif : Le seul horoscope qui se base sur la science !

Le 21 octobre 2019

Le Naïf et le Cosmologiste

Le 7 juillet 2014

L’astrologie « traditionnelle » a-t-elle encore un avenir ?

Le 3 février 2012

La cosmologie, victime collatérale de la guerre

Le 23 janvier 2012

Élizabeth Teissier : « l’année de sa vie »

Le 23 septembre 2011Communiqués de l'AFIS